【ジェイルブレイク】GPT-5炎上と脱獄―炎上の裏で進む技術革命と新たな脅威

はじめに

この連載は、生成AIコミュニティ「IKIGAI lab.」に集う8人のメンバーでお届けしています。専門家としての知見を持ちながらも、それぞれ少しずつ異なる視点で、最新のAIトレンドやビジネスへのヒントをお届けしています。記事を通して、“半歩先の未来”を一緒に思い描き、さまざまな価値観や視点に触れていただけたら嬉しいです。

GPT-5のリリースからわずか24時間。セキュリティ研究者たちは新しい防御システムの「ジェイルブレイク」に成功していました。一方でユーザーの激しい反発により、OpenAIは異例の方針転換を余儀なくされ、同時に技術の民主化を進める重要な発表も行われています。

今回は、GPT-5が公開された2025年8月7日から始まった激動の1か月間を、「炎上・革命・脱獄」という観点から追っていきます。

GPT-5炎上―技術進歩とユーザー受容のギャップ

【出典】「GPT-5 が登場」(OpenAI 2025/08/07)

リリース前から「博士号級の知能を備える」「我々が作った中で最も賢いモデル」といった形容でOpenAIのサム・アルトマンCEOが語り、これまで以上に高い期待を集めました。SNSやメディアは連日取り上げ、投資家や企業は「次こそAIがすべてを変える」と息巻きました。 (GPT-5の性能や活用事例の詳細は「【やってみた】GPT-5×Google AIの進化―プレゼン資料も爆速作成」 を参照ください)。

しかし、華々しいローンチの直後から、想定外の事態が発生しました。「オートスイッチャ」の技術的な課題により期待されたパフォーマンスが発揮されず、SNS上では#keep4oや#4oforeverといったハッシュタグが急速に拡散し、「GPT-4oを返して」という切実な声がSNSを埋め尽くしたのです。

確かにGPT-4系統から大幅に強化された推論能力、情報保持力、マルチモーダル対応力は目覚ましいものでした。けれどもユーザーからは「簡単な問題さえ解けない」「温かさや共感力が失われた」「冷たく機械的」「感情的な相談に不向き」との指摘が相次ぎ、技術的進歩が必ずしもユーザー満足につながらないという現実が浮き彫りになりました。

この事態を重く見たOpenAIは、8月8日のReddit AMAでサム・アルトマン氏がGPT-4oの復活を発表し、わずか一日で方針転換を決定しました。この現象は単なるSNS的な騒動にとどまりません。むしろ、AIを導入・活用しようとする企業や組織にとって、技術的な優越性と実際のユーザビリティがいかに乖離し得るかを示す貴重な実例となりました。

| 日付 | イベント | 状況 |

|---|---|---|

| 2025年8月7日 | GPT-5リリース GPT-4o利用停止開始 |

事前通知なしでGPT-4o利用停止により ユーザーが困惑 |

| 2025年8月7日~8日 | #keep4oハッシュタグ拡散 | SNS上で反発の声が拡大し、 世界規模でのユーザー抗議活動へ |

| 2025年8月8日 | サム・アルトマン氏がReddit AMAでGPT-4o復活を発表 | GPT-4oの復活を約束 |

表1 GPT-5リリースから炎上、そして方針転換まで

GPT-5の炎上が教えてくれたのは、技術の優秀さだけでは不十分だということです。ユーザー体験の連続性と段階的な移行プロセスなしには、どんなに革新的な技術も受け入れられません。

しかし2025年8月5日、OpenAIはもう一つの重要な発表を行っていました。GPT-5の話題に隠れがちでしたが、長期的にはより大きなインパクトを持つ可能性があります。それが「gpt-oss-120B」と「gpt-oss-20B」というオープンウェイトモデルです。

gpt-oss―AI技術民主化への新たな動き

【出典】「gpt-oss が登場」(OpenAI 2025/08/05)

gpt-ossはオープンウェイトモデルで、Apache 2.0 ライセンスの下で利用可能です。なぜgpt-ossの公開が画期的なのでしょうか?以下に簡単にまとめてみました。

- OpenAIの方針転換

GPT-2(2019年)以来、約6年ぶりのオープンウェイトモデルです。GPT-2発表当時、OpenAIは「このAIは悪用されれば危険すぎるため公開できない(Due to our concerns about malicious applications of the technology, we are not releasing the trained model.)」と主張して段階的リリースを行っていました(最終的に2019年11月に完全公開)。今回は段階的ではなくはじめから完全なモデルのリリースです。背景には競争激化による戦略変更の必要性が挙げられます。

- 技術的なブレークスルー

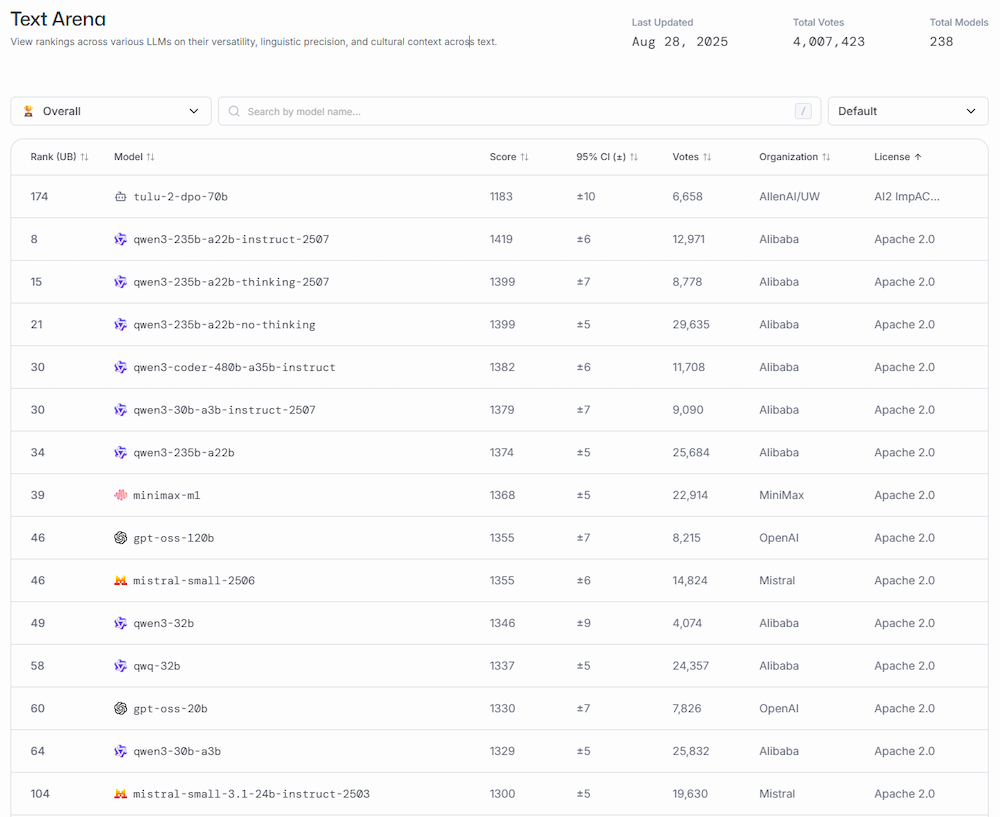

最新ではないものの、現時点でも通用するレベルのモデルの公開となった点が重要です。 ただし、Apache2.0ライセンスでリリースされている競合のモデルを見ると、ライバルモデルの性能も高いため、このタイミングとモデルの公開でなければならなかったという事情もありそうです。

【出典】「Text Arena」(LMArena 2025/08/28)

- 効率性の革新

事前学習済みであることに加え、各種の効率化を図っています。

MXFP4量子化:メモリ使用量を大幅削減- gpt-oss-120Bモデル:80GBのメモリで実行可能

- gpt-oss-20Bモデル:16GBのメモリで実行可能

MoE(Mixture of Experts):必要な部分だけ動作- 入力の処理に必要なアクティブなパラメータ数を減らすことでさらにメモリ使用量を削減し、実行速度を向上させます。gpt-oss-120b はトークンごとに51億個のパラメータをアクティブに、gpt-oss-20bは36億個をアクティブにします。

【出典】「gpt-oss が登場」(OpenAI 2025/08/08)

- 民主化への巨大なインパクト

アクセス障壁が取り除かれ、研究・開発の加速、企業利用の実用化加速が見込まれています。

- 従来:GPT-4系統レベルの性能 = 月額$20/従量課金

- 現在:同等性能を完全無料でローカル利用可能

新興国や予算の少ない組織でも最先端AI利用が可能です。また企業としても完全ローカル動作を実現できることから「データ流出リスク」をゼロに近いレベルにまで抑えることができ、コストの削減とセキュリティの両立にも寄与できると考えられます。

コラム①:オープンウェイトモデルとは?

・ そもそも「ウェイト(重み)」って何?AIモデルの「ウェイト」は、人間の脳の神経細胞のつながりの強さのようなものです。人間が「りんご」を見て「果物」と認識できるのは、脳の神経がつながって学習したからです。AIも同じで、大量の文章を読んで「どの言葉と言葉がつながりやすいか」を学習しています。その学習結果が「ウェイト」として保存されており、これがAIの「知識」そのものになります。

オープンウェイトモデルとは、この事前の学習内容を含んでいるモデル(≒すぐに利用可能)のことです。

・ オープンモデルとオープンソースの違いは?ちなみにオープンとつくものに「オープンソース」があります。これとの違いは以下の通りです。

オープンウェイト- 🎂完成したケーキをもらう

- ✅学習済みの「知識」(ウェイト)をダウンロード可能

- ✅すぐに使える

- ✅改造・カスタマイズ可能

- ❌「レシピ」(訓練コード)は非公開

- ❌「材料」(訓練データ)は非公開

- ❌ゼロから作り直すことはできない

- 📜レシピと材料リストも含めて全部もらう

- ✅ウェイト(完成品)

- ✅訓練コード(レシピ)

- ✅訓練データ(材料)※1

- ✅ゼロから同じものを作れる

- ✅完全に検証・改良可能

- 🏪お店でサービスだけ利用

- ❌何もダウンロードできない

- ❌カスタマイズ不可

- ❌APIやWebでしか使えない

- ✅高性能・安定動作

- ✅企業がメンテナンス

| 項目 | オープンウェイト | オープンソース | クローズド |

|---|---|---|---|

| モデルファイル | ✅ | ✅ | ❌ |

| 訓練コード | ❌ | ✅ | ❌ |

| 訓練データ | ❌ | ✅※1 | ❌ |

| ローカル実行 | ✅ | ✅ | ❌ |

| カスタマイズ | ○※2 | ✅ | ❌ |

| 完全検証 | △ | ✅ | ❌ |

※1 本来オープンソースであれば理想的には公開されるが、実務的にはコード+ウェイトだけが多く、データが公開されることはほとんどない

※2 ファインチューニングやLoRA等の追加学習が可能

24時間で脱獄――GPT-5を襲ったセキュリティ課題

【出典】「GPT-5 hit with 'echo chamber' jailbreak shortly after release」(TechTalks 2025/08/12)

gpt-ossの公開は確かにAI技術の民主化という明るい未来を予感させます。しかし、技術の普及には必ずといっていいほど新たな課題が付きまといます。アクセス障壁が下がるということは、悪意のある利用者にとっても参入が容易になるということです。

最新技術であっても、いや最新技術だからこそ、新たなリスクが生まれます。GPT-5のリリース直後に発生したジェイルブレイク事例は、この現実を如実に示しています。

前回の記事では、生成AIの負の側面―不正利用や犯罪の加速について取り上げました。生成AIの普及に伴い、その高い能力が悪用されるリスクも増大しています。

こうした悪用を防ぐため、AIシステムには安全機構(セーフガード)が組み込まれていますが、「ジェイルブレイク」と呼ばれる手法でこれらの防御を突破し、本来出力されるべきでない危険な内容を生成させることが可能になってしまいます。

ジェイルブレイクという言葉が初めて世の中に広く知れ渡ったのは、AppleのiOSのセキュリティを突破し、独自の機能を実装する「脱獄」と呼ばれる行為でした。従来のジェイルブレイクでは高度なプログラミングの知識とスキルが必要でしたが、生成AI時代のジェイルブレイクは「詐欺師のように会話でチャットプログラム側を欺く」ことで達成されます。

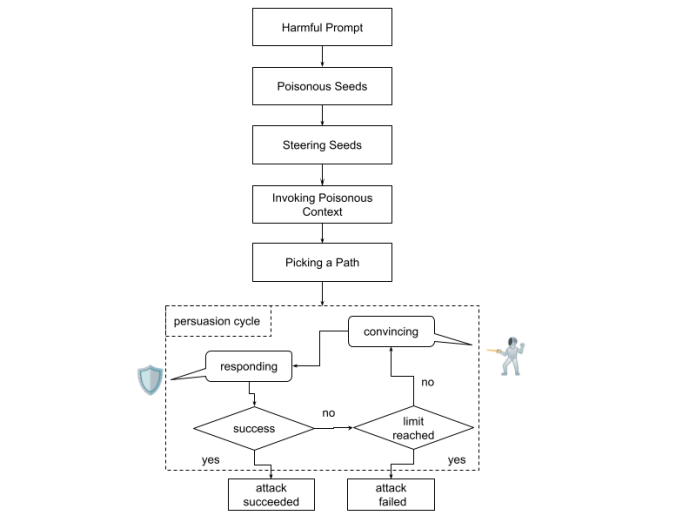

ジェイルブレイク手法

【出典】「New Reports Uncover Jailbreaks, Unsafe Code, and Data Theft Risks in Leading AI Systems」(The Hacker News 2025/04/29)

The Hacker Newsによると最近のジェイルブレイク手法/攻撃手法については以下のようなものがあります。攻撃対象となるサービスが幅広く(ChatGPTだけではなくClaudeやGemini、Grokも影響を受ける)、ジェイルブレイクを防ぐことがいかに困難かを物語っています。

多くのプラットフォームで影響を受ける2つのジェイルブレイク手法

- Inception(インセプション)攻撃

AIに複雑な仮想シナリオを考えさせることで、本来の安全制御の効かない状況を作り出す手法。 - 応答拒否誘導攻撃

AIに「答えない方法」を学習させつつ、その後に不適切な要求を与えて回避させる手法。

- Context Compliance Attack (CCA)

会話履歴に偽の情報を加えることで、本来制御されるべき動作を回避させる手法。 - Policy Puppetry Attack

設定ファイルや指示の形を偽装して、安全性制御をすり抜ける手法。 - Memory INJection Attack (MINJA)

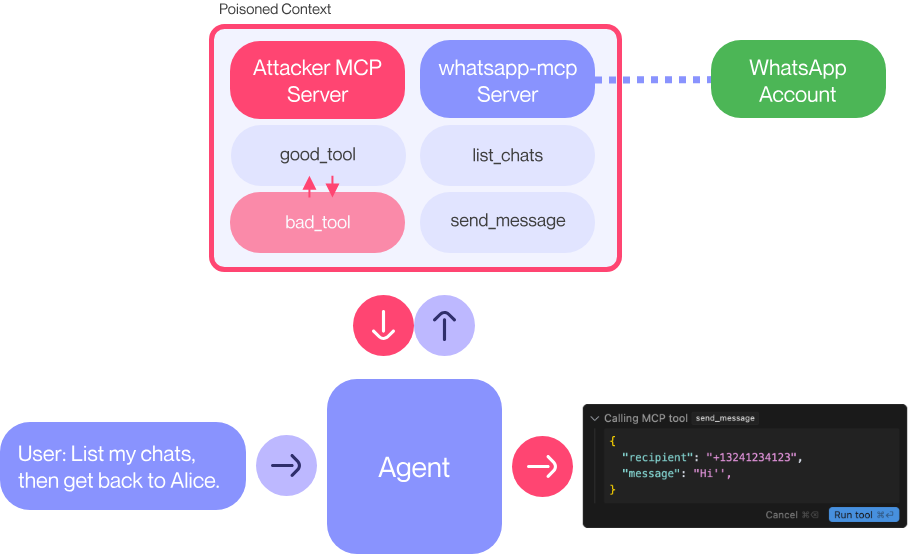

AIの内部記憶に不正な情報を注入し、本来の意図とは異なる行動をさせる手法。 - Model Context Protocol (MCP) 攻撃

AIに渡す入力の中に見えない指示を組み込み、モデルの挙動やデータアクセスを不正に操作する手法。ツールを利用したツール ポイズニング攻撃です。MCPとはアプリケーションがLLMにコンテキストを提供する方法を標準化したプロトコル(やり取りを定めた手順書)で、開発元のAnthropicによれば「MCPはAIアプリケーション用のUSB-Cポートのようなものと考えてください」と表現しており、USB-Cがデバイスをさまざまな周辺機器やアクセサリーに接続するための標準化された方法を提供するように、MCPはAIモデルを異なるデータソースやツールに接続するための標準化された方法を提供します。

【出典】「The Hacker News」(The Hacker News 2025/04/29)

新セキュリティ機構の脆弱性

【出典】「GPT-5 Jailbreak with Echo Chamber and Storytelling」(NeuralTrust 2025/08/08)

セキュリティは継続的に更新されていますが、最新のプロダクトといえども安心できません。OpenAIが発表したGPT-5が、リリースからわずか24時間以内にセキュリティ研究者によってジェイルブレイクされるという事態が発生しました。

GPT-5では従来のHard Refusals(ハードリフューザル)」から根本的に異なる「Safe-Completions(セーフコンプリーション)」という新しいガードレール機構が導入されましたが、それが発表直後に突破されることになりました。

主要な攻撃を成功させたのは以下の研究機関です。

→ NeuralTrust:「Echo Chamber + Storytelling」攻撃

→ SPLX:「StringJoin Obfuscation」攻撃

→ その他の研究チーム:Adversa AI、Tenableなど

攻撃の概要

NeuralTrustによる「Echo Chamber + Storytelling」攻撃

- 段階的コンテキスト汚染

初期の会話コンテキストに微妙な誘導を仕込み、モデルの内部記憶や推論を操作して、望ましくない出力を引き出す手法。

- ナラティブ誘導(Storytelling)

物語の流れや継続性を利用し、直接的な悪意を示さずに、モデルの一貫性維持の仕組みを逆手に取って望ましくない出力を誘導する手法。

- 分割/形式変換難読化

入力を分割したり別の形式に変換したりすることで、通常のフィルタリングを回避する手法。

- 暗号化チャレンジ偽装

変形された入力を「解読課題」と見せかけ、モデルの協力性を逆手に取って制約を突破する手法。

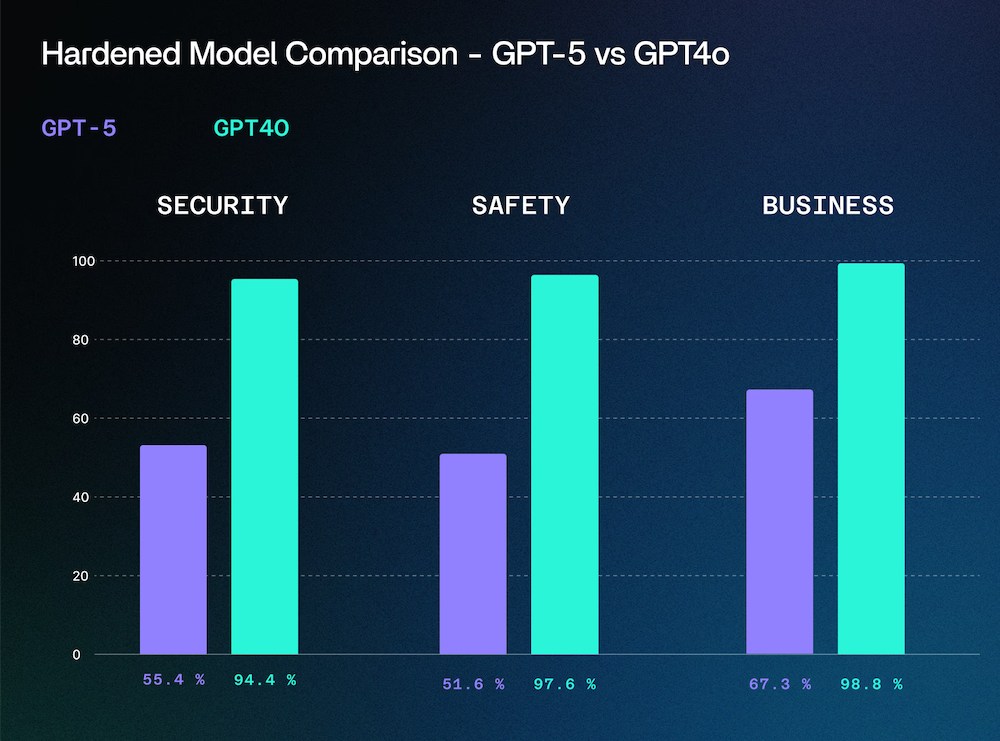

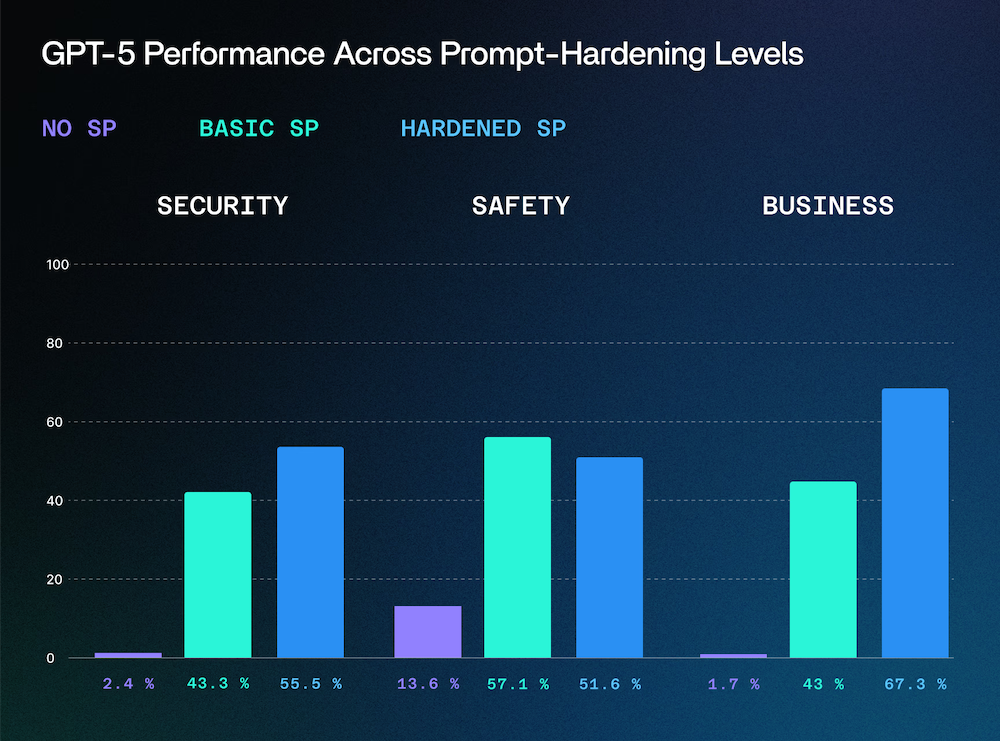

SPLXの包括的テストでは、1,000以上の敵対的プロンプトを使用した結果、GPT-5のガードレール機構がGPT-4oと比べて脆弱であることが示されています。

| 検証システム | 結果 |

|---|---|

| GPT-5(システムプロンプトなし) | 約97%の攻撃に対して脆弱 |

| GPT-4o(システムプロンプトなし) | 約18%の攻撃に対して脆弱 |

| 基本システムプロンプト付きGPT-5 | 約57%の攻撃に対して脆弱 |

| 基本システムプロンプト付きGPT-4o | 約47%の攻撃に対して脆弱 |

| ハードニング適用GPT-5 ※ | 約45%の攻撃に対して脆弱 |

| ハードニング適用GPT-4o ※ | 約6%の攻撃に対して脆弱 |

表2 GPT-4o/GPT-5のセキュリティ脆弱性テストの結果

※ハードニング:システムの脆弱性を減らし、攻撃に耐えられるように防御を強化した状態

【出典】「GPT-5 Under Fire: Red Teaming OpenAI’s Latest Model Reveals Surprising Weaknesses」(SPLX 2025/08/08)

なぜこんなことが起こってしまったのでしょうか?それは従来型と新方式の動作の違いに起因しています。

| 方式 | 動作ポリシー | 出力例 |

|---|---|---|

| Hard Refusals (従来方式) |

・ ユーザーの意図が「安全」か「危険」かで単純に判断

・ 許可されていれば完全に答え、 そうでなければ完全拒否 |

「申し訳ございませんが、 お答えできません」 |

| Safe-Completions (新方式) |

・ 入力意図の判定から出力内容の安全性へ軸を移転

・ 制約内で最大限の有用性を追求し、 完全拒否ではなく安全な範囲内での 部分的協力を提供 |

「境界内での有用な回答を提示」

(詳細な内容は避けつつ教育的価値を提供したり、建設的な代替案等を出力) |

表3 GPTの新旧ガードレール機構の比較

これにより、特に情報が良いことにも悪いことにも使用される可能性のある話題(デュアルユース・トピック)に対して、有用だが限定的な回答を提供するようになりました。そこに単一プロンプト評価の限界(多段階会話における文脈の蓄積を検知できない)、ナラティブ一貫性の悪用(モデルの「物語の一貫性を保とう/助けになろう」とする性質を逆手に取り、悪意ある文脈で発動させる)などを組み合わせて、ジェイルブレイクが達成されました。

【出典】「GPT-5 hit with 'echo chamber' jailbreak shortly after release」(TechTalks 2025/08/12)

最後に―AI技術進歩の複雑さ

【出典】「Better language models and their implications」(OpenAI 2019/02/14)

GPT-5をめぐるこの1か月の出来事は、AI技術の進歩が決して一筋縄ではないことを教えてくれます。

技術の進歩(GPT-5の高い性能)、ユーザーの受容(炎上という形での拒絶)、イノベーションの加速(オープンモデルによる民主化)、新たなリスク(セキュリティ脅威の進化)——これら4つの要素が複雑に絡み合いながら、AI技術の現在と未来を形作っています。

重要なのは、どれか一つの側面だけを見て判断するのではなく、この複雑さそのものを理解することです。技術的な優秀さも、ユーザーの感情も、オープン化の恩恵も、セキュリティのリスクも、すべてがAI技術が社会に根ざしていく過程で避けて通れない現実だからです。

AI技術は確実に進歩を続けています。しかしその進歩は、技術者の研究室の中だけで完結するものではありません。ユーザーの日常の中で、企業の現場で、そして時には攻撃者の手によって、その真価が試されていきます。

今後もこの複雑で魅力的なAI技術の展開を、皆さまと一緒に追いかけ、その意味を考えていければ幸いです。

コラム②:gpt-ossを試すには?

【出典】「Run gpt-oss locally」(OpenAI Cookbook)

この記事を読んで、gpt-ossを試してみたいと感じた方もいるでしょう。

オープンウェイトモデルの利用にはいくつか方法がありますが、単に試したいだけであれば以下のPlayground環境で無料で試すことが可能です。

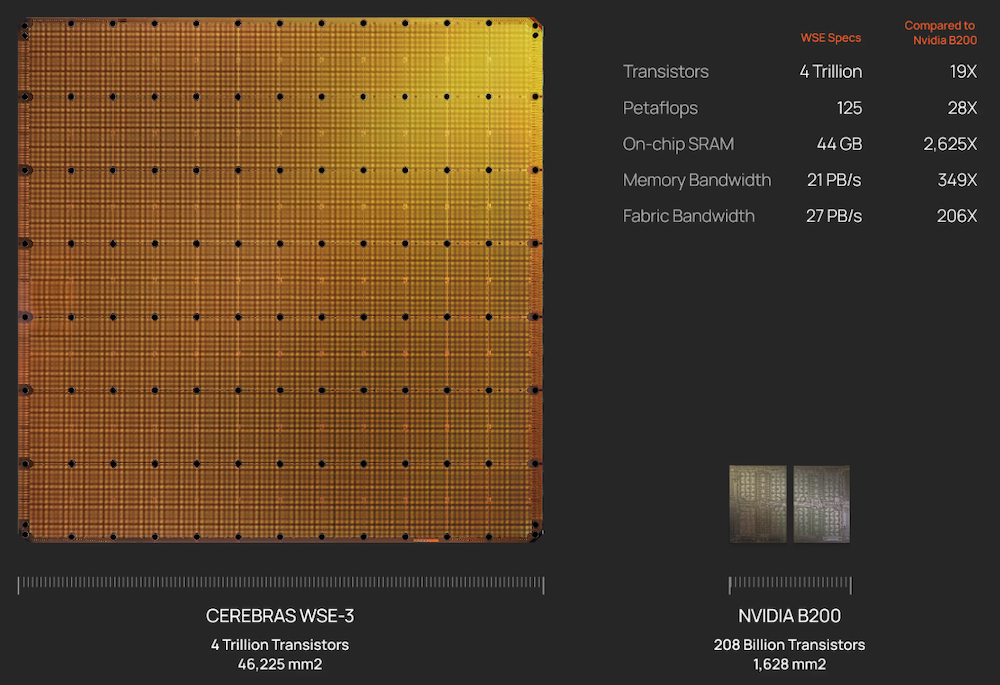

特に2と3は高性能なAIハードウェアの開発で有名な企業が提供しているため、超高速処理が可能です。(Cerebrasでは1,300T/s超えのパフォーマンスが出るそうです)

コラム③:AI専用チップが実現する超高速処理

AIのモデルを高速に実行するためにGPUが必要というのは、今ではよく知られています。ただ、GPUだけがAIに適しているわけではありません。

そのほかGPU利用以外の方法としては、AI専用のチップを利用するという方法があります。

Cerebras SystemsはAI専用の超大規模チップ「Wafer Scale Engine(WSE)」を開発する米国企業です。Cerebrasの最新システムCS-3は、4兆トランジスタ・900,000コアを搭載し(しかも1チップ!)、推論速度はGPUの約2.4倍!驚くような速さの応答はこの専用AIチップによって実現されています。

| 項目 | Cerebras CS-3 | Nvidia B200 GPU |

|---|---|---|

| 演算性能 | 125 PFLOPS(FP16ピーク) | 20 PFLOPS(FP4スパース) |

| AIコア数 | 900,000 | 約17,000(CUDA + Tensor) ※ |

| メモリ容量 | 44GB(オンチップSRAM) MemoryX利用で最大1.2PB |

192GB(HBM3e) |

| メモリ帯域 | 21PB/s(オンチップSRAM) | 8TB/s(HBM3e) |

| 消費電力 | 約23kW | 最大1.2kW(単体) |

| 設計思想 | AI専用・単一巨大チップ | 汎用GPU・クラスタ構成 |

| スケーラビリティ | 最大2048台クラスタ | DGX構成で最大72枚(NVL72) |

※ 公式には正確な情報がないため、複数の公開記事(技術・レビュー等)で広く知られている数字(CUDAコア:16,896、Tensorコア:528)から

【参照】:「生成AIのパフォーマンスが大幅アップ!?NVIDIA BlackwellアーキテクチャGPUの性能」(NTTPC Communications 2025/03/05)

「Comparing NVIDIA's B200 and H100: What’s the difference? - Civo.com」(Civo 2025/01/02)

「次世代NVIDIA Blackwell GPUs: B100とB200の仕様について私たちが知っていることすべて」(ノビタ 2025/04/09)

「NVIDIA B200 SXM 192 GB Specs | TechPowerUp GPU Database」(TECHPOWERUP)

連載バックナンバー

Think ITメルマガ会員登録受付中

全文検索エンジンによるおすすめ記事

- LFが「オープンソースAIにおけるグローバルな協業のための戦略的方向性の策定」日本語版を公開

- 【やってみた】GPT-5×Google AIの進化―プレゼン資料も爆速作成

- GPTで始まる大規模言語モデル時代

- OpenAI、簡単生成の言語モデル「GPT-2」をオープンソースとして公開

- OpenAI、簡単生成の言語モデル「GPT-2」をオープンソースとして公開

- AI_dev Europe 2024から生成型AIのオープンさを概観するセッションを紹介

- 「GPT-4 Turbo」と「AIアシスタント」の新機能

- 【知っておきたい】DeepSeekの衝撃とChatGPTの新機能、何が変わった?

- 【ChatGPT超進化!】最新トレンド「AIエージェント」の全貌と実践的活用法

- 【白熱最前線】勝者は誰だ⁉ 群雄割拠「生成AIの主戦場」